- Page d'accueil

- Actualité

- ADAS & détection d’objets via des systèmes de caméras : le développement rapide

ADAS & détection d’objets via des systèmes de caméras : le développement rapide

À peu près au même moment que l’introduction de la première Tesla Model S, un autre nouveau nom est apparu dans l’industrie automobile : Mobileye. Alors que de nombreux autres développeurs de capteurs pour la détection d'objets se concentraient principalement sur un grand nombre et d'énormes quantités de données préchargées (cartes 3D de l'environnement), Mobileye s'est principalement concentré sur un système de caméra (l'œil mobile) capable de gérer des phénomènes réels. situations temporelles complètement par lui-même.peut estimer. Dans cet article, nous discutons des différentes versions de conduite autonome que cela rend possibles et de la manière dont ce développement va se poursuivre.

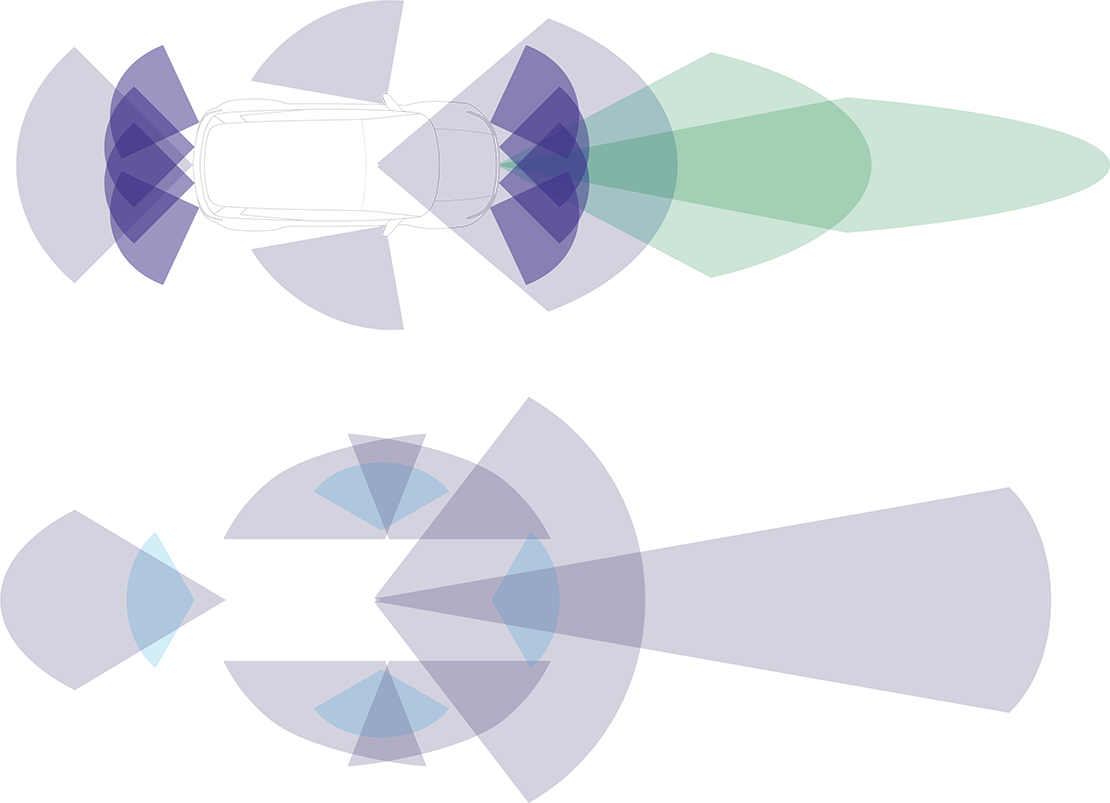

Image : Représentation schématique du fonctionnement traditionnel de l'ADAS (en haut) par rapport au fonctionnement de l'ADAS selon Mobileye (en bas)

Mobileye EyeQ : niveau d'autonomie 2+

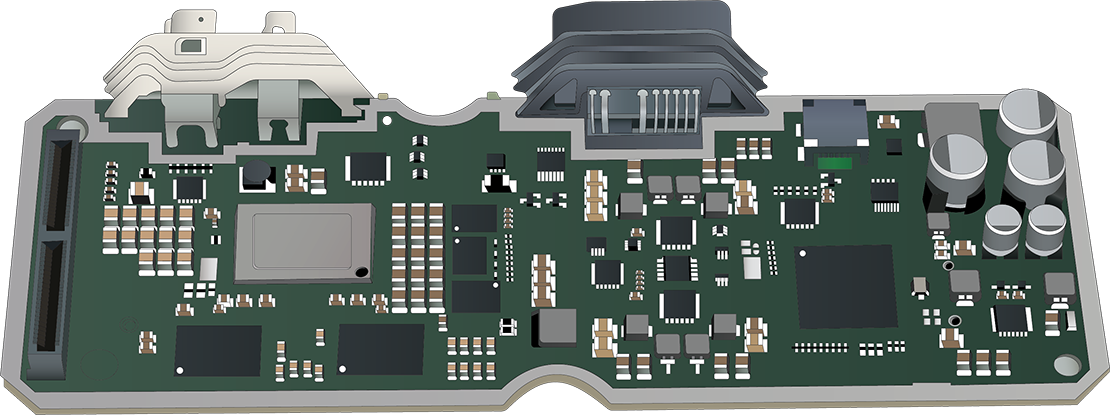

L'EyeQ est la base de la technologie de caméra uniquement de Mobileye : un SoC (System on Chip) spécialement développé. Dès son introduction en 2007, l'EyeQ a attiré l'attention de plusieurs grands constructeurs automobiles, qui recherchaient un partenaire capable de fournir un système ADAS complet. Plus de 100 millions (!) d'EyeQ ont désormais été vendus dans le monde, répartis sur plus de 700 modèles de voitures provenant de plus de 35 constructeurs automobiles différents. Le dernier modèle haut de gamme en 2023, l'EyeQ6H, possède son propre processeur de signal d'image interne (ISP), un processeur graphique (GPU) et un encodeur vidéo. Cela permet de contrôler des systèmes avec un niveau d'autonomie 2+. Même les formes d’ADAS les plus haut de gamme ne posent aucun problème pour ce SoC. Avec un matériel de ce calibre, il n’est probablement pas surprenant que cette technologie offre de nombreuses fonctionnalités. Des fonctions telles que l'avertissement de sortie de voie, l'assistance au maintien de voie, le freinage d'urgence automatique, l'avertissement de collision frontale, le régulateur de vitesse adaptatif, la reconnaissance des panneaux de signalisation, l'assistance aux feux de route et l'assistance au stationnement sont toutes possibles avec le SoC EyeQ. Dans certains cas, la caméra centrale reçoit encore l'assistance du radar.

Image : Un aperçu de l'intérieur de l'EyeQ

Mobileye REM : niveau d'autonomie 3

Afin d'atteindre le niveau d'autonomie 3 ou supérieur sans utiliser de nombreux capteurs ou des cartes 3D à grande échelle, Mobileye a recherché un moyen alternatif d'obtenir des connaissances préalables, avec lequel EyeQ aurait plus d'informations que ce que la caméra avait en vue à ce moment-là.

La solution est arrivée en 2018 sous la forme du Road Experience Management (REM). Fondamentalement, il s’agit d’un système dans lequel chaque voiture équipée d’un nouveau SoC EyeQ stocke en permanence des informations sur le monde vu par la caméra. Toutes ces informations sont collectées de manière centralisée et converties en un Roadbook : sa propre carte en temps réel dans laquelle non seulement l'environnement est connu, mais il devient également clair comment et avec quel positionnement le tronçon de route est utilisé. Toutes ces informations sont ensuite partagées Over-The-Air (OTA) avec les autres véhicules EyeQ, qui peuvent alors prendre de meilleures décisions en mode autonome.

Vous pourriez imaginer que, étant donné le nombre énorme de SoC EyeQ en circulation, cela conduira rapidement à un tout complet et pratique. D’autant plus que ce système peut également estimer dans une certaine mesure le comportement de conduite local et adapter le comportement de conduite autonome en conséquence. Par exemple, une fusion rapide est bien plus importante au milieu d’une ville animée qu’à la campagne.

Mobileye SuperVision ADAS

Plus l’ADAS peut regarder autour de lui, plus un tel système fonctionne mieux et plus il y a de fonctionnalités possibles. SuperVision a donc été introduit en collaboration avec le constructeur automobile Geely : une forme très étendue d'ADAS avec pas moins de 7 caméras environnementales, 4 caméras de stationnement et 2 SoC.

Cette mise à niveau massive permet au SuperVision ADAS de réagir beaucoup plus comme le ferait un pilote physique. Par exemple, si quelqu'un est garé le long de la route avec la porte ouverte, le système maintiendra un peu plus de distance (latérale). Et si un piéton passe à proximité du tronçon de route, le véhicule réduit sa vitesse. Le système est également capable d’anticiper beaucoup mieux les situations de circulation telles que les fusions et les objets qui changent soudainement de direction. Bref, une belle évolution.

Radar et LiDAR en secours

Pour que les véhicules puissent rouler de manière totalement autonome (niveau 5), un niveau de sécurité considérable doit être intégré aux systèmes. Et si, comme Mobileye, vous comptez uniquement sur des caméras, vous rencontrerez rapidement des problèmes. Non pas parce que la conduite autonome à l'aide de caméras seules n'est pas possible, mais simplement parce qu'il n'y a pas de sauvegarde pour vérifier si les caméras voient la bonne chose et que le système effectue donc la bonne évaluation. C’est pourquoi le choix a été fait d’utiliser à la fois le radar et le LiDAR. L’approche est tout simplement très différente, comme le montre également le tableau ci-dessous. Mobileye ne considère pas le radar et le LiDAR comme un complément pour compléter les informations, mais fait suffisamment confiance à son propre système de caméra pour considérer le radar et le LiDAR uniquement comme un moyen de contrôle. Ils appellent cela une « véritable redondance ».

Nvidia s'implique également dans la conduite autonome

Alors que Mobileye se concentre principalement sur un système universellement applicable qui peut être mis en œuvre relativement facilement n'importe où, le géant de la technologie Nvidia a toujours vu différemment les problèmes liés à la conduite autonome et à l'énorme quantité de données qui y est associée. Parce que Nvidia a ses racines dans l’industrie informatique (graphique), ils ne considèrent pas la détection d’objets comme un système distinct, mais comme faisant partie d’un ensemble plus vaste : la voiture dans son ensemble. En fait, un peu comme une carte graphique fait partie d’un PC complet.

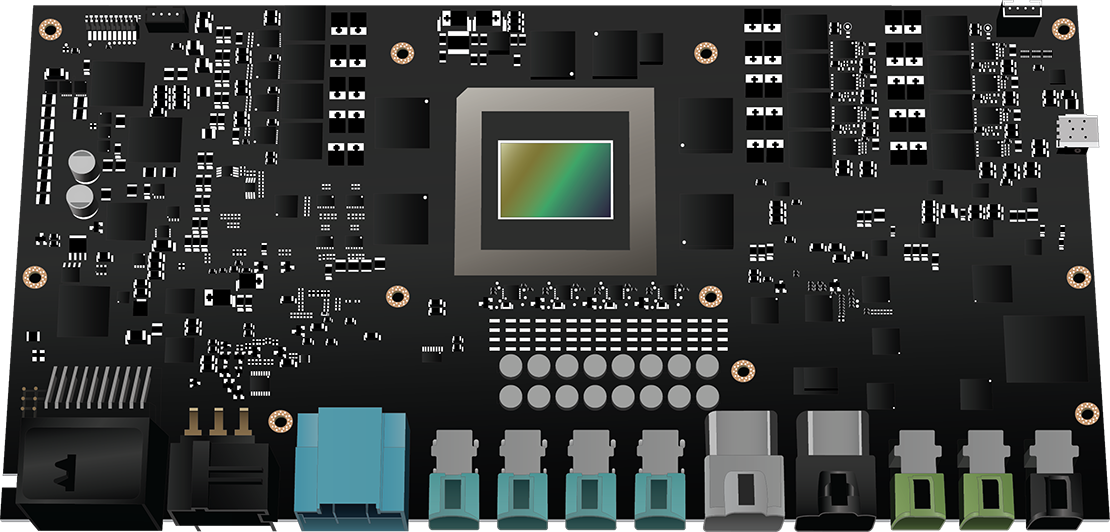

Image : Le Nvidia DRIVE Thor en détail

En septembre 2022, Nvidia a annoncé le « DRIVE Thor », un ordinateur central complet qui contrôle également des systèmes tels que la conduite et le stationnement autonomes, la surveillance des occupants, l'infodivertissement et le tableau de bord numérique. L'énorme puissance de calcul (2000 téraflops) est le point fort de Thor et rend totalement inutile plusieurs unités de contrôle distinctes. La plateforme permet également le calcul multidomaine, qui permet par exemple à la conduite autonome de fonctionner de manière totalement indépendante et donc en toute sécurité en complément des autres fonctions de ce supercalculateur.

Comment la détection d'objets influencera la gestion du moteur

Il est probablement devenu clair pour vous que tous ces systèmes peuvent énormément influencer les choix du calculateur. Le message que nous voulons transmettre avec ces informations est que le diagnostic avec cette nouvelle technologie ne sera plus jamais le même : la pédale d'accélérateur n'est plus la seule entrée à laquelle la gestion moteur doit répondre. Trouver la cause d'un dysfonctionnement devient alors une histoire complexe : le calculateur est-il vraiment défectueux ? Ou est-ce qu'il ne reçoit tout simplement pas la bonne entrée ? Et la cause est-elle ailleurs dans la voiture ?

da

da de

de en

en es

es it

it nb

nb nl

nl pt

pt sv

sv fi

fi